Estimación de máxima verosimilitud

La Estimación de Máxima Verosimilitud (EMV) es un modelo general para estimar parámetros de una distribución de probabilidad que depende de la muestra.

La Estimación de Máxima Verosimilitud (EMV) es un modelo general para estimar parámetros de una distribución de probabilidad que depende de las observaciones de la muestra.

En otras palabras, la EMV maximiza la probabilidad de los parámetros de las funciones de densidad que dependen de la distribución de probabilidad y las observaciones de la muestra.

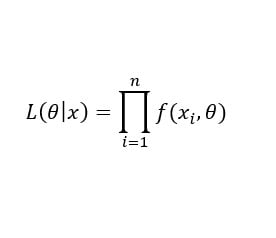

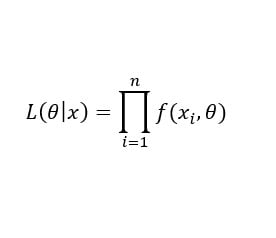

Cuando hablamos de estimación de máxima verosimilitud, debemos hablar de la función de máxima verosimilitud. Matemáticamente, dada una muestra x=(x1,…,xn) y parámetros, θ = (θ1, … , θn) entonces,

¡Que no cunda el pánico! Este símbolo significa lo mismo que el sumatorio para las sumas. En este caso, es la multiplicación de todas las funciones de densidad que dependen de las observaciones de la muestra (xi) y de los parámetros θ.

Cuanto más grande el valor de L(θ | x), es decir, el valor de la función de máxima verosimilitud, más probables serán los parámetros basados en la muestra.

Función logarítmica de EMV

Para encontrar las estimaciones de máxima verosimilitud tenemos que diferenciar (derivar) los productos de funciones de densidad y no es la manera más cómoda de hacerlo.

Cuando nos encontramos con funciones complicadas, lo que podemos hacer es una transformación monótona. En otras palabras, sería como querer dibujar Europa a escala real. Deberíamos reducir la escala para que pudiese caber en una hoja de papel.

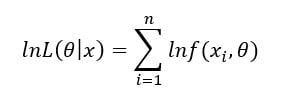

En este caso, la transformación monótona la hacemos mediante logaritmos naturales dado que son funciones monótonas y crecientes. Matemáticamente,

Las propiedades de los logaritmos nos permiten expresar la multiplicación anterior como el sumatorio de logaritmos naturales aplicados a las funciones de densidad.

Entonces, la transformación monótona mediante logaritmos simplemente es un “cambio de escala” hacia números más pequeños.

El valor estimado de los parámetros que maximice la probabilidad de los parámetros de la función de máxima verosimilitud con logaritmos es equivalente al valor estimado de los parámetros que maximice la probabilidad de los parámetros de la función de máxima verosimilitud original.

Entonces, siempre vamos a tratar con la modificación monótona de la función de máxima verosimilitud dada su mayor facilidad para los cálculos.

Curiosidad

Por muy complejo y extraño que parezca la EMV, la estamos aplicando continuamente sin darnos cuenta.

¿Cuando?

En todas las estimaciones de los parámetros de una regresión lineal bajo supuestos clásicos. Más comúnmente conocidos como Mínimos Cuadrados Ordinarios (MCO).

En otras palabras, cuando estamos aplicando MCO, estamos aplicando EMV implícitamente dado que ambos son equivalentes en términos de consistencia.

Aplicación

Al igual que otros métodos, la EMV se basa en la iteración. Es decir, repetir una operación determinada tantas veces como requiera para encontrar el valor máximo o mínimo de una función. Este proceso puede estar sujeto a restricciones en los valores finales de los parámetros. Por ejemplo, que el resultado sea superior o igual a cero o que la suma de dos parámetros tiene que ser inferior a uno.

El modelo simétrico GARCH y sus diferentes extensiones se aplica la EMV para encontrar el valor estimado de los parámetros que maximiza la probabilidad de los parámetros de las funciones de densidad.